顶部:当增加ε时,目标类别与其它类别之间的理论差距减小 。下图:最大预测与其它类别平均值之间差距的经验分布 。很明显,通过标签平滑,分布中心处于理论值并具有较少的极端值 。5.3 知识蒸馏在知识蒸馏 [10] 中,我们使用教师模型来帮助训练当前模型(被称为学生模型) 。教师模型通常是具有更高准确率的预训练模型,因此通过模仿,学生模型能够在保持模型复杂性相同的同时提高其自身的准确率 。

一个例子是使用 ResNet-152 作为教师模型来帮助训练 ResNet-50 。5.4 混合训练在混合训练(mixup)中,每次我们随机抽样两个样本 (x_i,y_i) 和 (x_j,y_j) 。然后我们通过这两个样本的加权线性插值构建一个新的样本:其中 λ∈[0,1] 是从 Beta(α, α) 分布提取的随机数 。

在混合训练中,我们只使用新的样本 (x hat, y hat) 。5.5 实验结果表 6:通过堆叠训练改进方法,得到的 ImageNet 验证准确率 。基线模型为第 3 节所描述的 。6 迁移学习6.1 目标检测表 8:在 Pascal VOC 上评估各种预训练基础网络的 Faster-RCNN 性能 。6.2 语义分割表 9:在 ADE20K 上评估各种基础网络的 FCN 性能 。

cnn卷积神经网络中的卷积核怎么确定?

卷积参数是模型学习出来的,卷积核的大小以及个数是人工来确定的,二维卷积卷积核大小一般是1*1,3*3,5*5,7*7这样奇数的 。卷积核的个数就是网络的channel数,常见的128 256 512这种,需要根据具体任务确定 。另外最近神经网络自动搜索结构非常火,最有名的就是谷歌的NASnet,采用某种启发式遍历来寻找对于特定数据集最优的网络结构 。

如何理解卷积神经网络里卷积过滤器的深度问题?

我们通常看到的卷积过滤器示意图是这样的:(图片来源:cs231n)这其实是把卷积过滤器“压扁”了,或者说“拍平”了 。比如,上图中粉色的卷积过滤器是3x3x3,也就是长3宽3深3,但是示意图中却画成二维——这是省略了深度(depth) 。实际上,卷积过滤器是有深度的,深度值和输入图像的深度相同 。也正因为卷积过滤器的深度和输入图像的深度相同,因此,一般在示意图中就不把深度画出来了 。

如果把深度也画出来,效果大概就是这样:(图片来源:mlnotebook)如前所述,卷积过滤器的深度和输入图像的深度相同,都是3 。顺便说下,输入图像深度为3,是因为输入图像是彩色图像,深度为3,分别为R、G、B值 。作为对比,灰度图像的卷积过滤器是这样的(真2D):(图片来源:mlnotebook)总之,卷积过滤器的深度和输入数据的深度保持一致就可以了 。

深度学习的人工神经网络及卷积神经网络原理是什么?

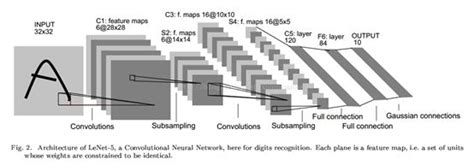

一、神经网络,也指人工神经网络(Artificial Neural Networks,简称ANNs),是一种模仿生物神经网络行为特征的算法数学模型,由神经元、节点与节点之间的连接(突触)所构成,如下图:每个神经网络单元抽象出来的数学模型如下,也叫感知器,它接收多个输入(x1,x2,x3...),产生一个输出,这就好比是神经末梢感受各种外部环境的变化(外部刺激),然后产生电信号,以便于转导到神经细胞(又叫神经元) 。

单个的感知器就构成了一个简单的模型,但在现实世界中,实际的决策模型则要复杂得多,往往是由多个感知器组成的多层网络,如下图所示,这也是经典的神经网络模型,由输入层、隐含层、输出层构成 。人工神经网络可以映射任意复杂的非线性关系,具有很强的鲁棒性、记忆能力、自学习等能力,在分类、预测、模式识别等方面有着广泛的应用 。

推荐阅读

- 空调变频板原理图,变频空调的原理及其电力工作原理是怎样的

- 家用空气能热水器原理,热水器禁止使用软水是什么意思

- 剖析声音定位原理,声源定位

- 太阳能电池的工作原理,perc太阳能电池原理

- 投影机原理,DLP投影机工作原理是什么

- 等离子切割机原理,请问等离子切割器工作原理是什么

- 秒懂Dubbo接口,dubbo原理

- 电机抱闸原理是什么,三相电机改二相方法

- 小苏打火山爆发的原理

- 蒸发式冷凝器工作原理是什么?它有什么优点与缺点?