不同于一般的卷积,空洞卷积的卷积核更加“蓬松”,也就是在卷积核中加入空洞,以此来扩大感受野 。路径A具有三个卷积,其卷积核大小分别为1×1、3×3和1×1 。这里所谓的卷积并不是数学意义上的,神经网络的卷积运算实际上可以看做一种比较特殊的矩阵计算,即将图中的局部像素矩阵和卷积核进行运算(符号是和直积一样,但不是直积,公式网上很多),所以可以将其视为空间泛函,每次运算所得到是对应位置的实数(这里是一次,不是一趟),使用一个卷积核′卷'一趟所得到的输出一般是一个规模小一些的矩阵,不同卷积核(内容不同)自然可以得到不同的输出,故形成图像不同的特征(所以这里也可以把这里的卷积理解为一种空间间映照算子);在网络反馈时,需注意对于卷积的逆运算,即需旋转卷积核180度(当然不用真的旋转,可以inplace,即从后向前运算,就能达到相同效果) 。

如何理解空洞卷积?

CNN网络中在对图像进行下采样时,常常使用pooling操作,包括average pooling和max pooling 。其作用在仿照人的视觉系统进行降维,同时扩大了感受野(perceptual field) 。对卷积层提取的特征进行降采样,从而能够获取到更高级的特征 。此外pooling层也可以保证特征位置和旋转不变形 。

最后引入pooling还能起到降少网络参数,防止过拟合的问题 。但是采用pooling也有其缺点,在降采样的同时也会丢失一部分特征信息,损失了原始图像中的信息 。空洞卷积(diluted convolution)就是为解决pooling层的缺点而提出的 。它首先是针对图像语义分割而产生的一种卷积方法 。不同于一般的卷积,空洞卷积的卷积核更加“蓬松”,也就是在卷积核中加入空洞,以此来扩大感受野 。

引入了一个新的参数空洞率(dilation rate),即卷积核的间隔数目,正常卷积核的空洞率等于1 。如下图就是一个空洞率为2的3*3空洞卷积 。我们可以发现,空洞卷积不仅扩大了感受野降低了维度,同时没有增加计算量 。但是由于引入了一个超参数,就需要权衡每次卷积时的参数,如果空洞率过大,那么就很有可能捕捉不到图像中小物体的信息,因此再使用时需要设置好合适的空洞率 。

如何理解Graph上的卷积操作?

这里所谓的卷积并不是数学意义上的,神经网络的卷积运算实际上可以看做一种比较特殊的矩阵计算,即将图中的局部像素矩阵和卷积核进行运算(符号是和直积一样,但不是直积,公式网上很多),所以可以将其视为空间泛函,每次运算所得到是对应位置的实数(这里是一次,不是一趟),使用一个卷积核′卷'一趟所得到的输出一般是一个规模小一些的矩阵,不同卷积核(内容不同)自然可以得到不同的输出,故形成图像不同的特征(所以这里也可以把这里的卷积理解为一种空间间映照算子);在网络反馈时,需注意对于卷积的逆运算,即需旋转卷积核180度(当然不用真的旋转,可以inplace,即从后向前运算,就能达到相同效果) 。

【图像的卷积和池化操作,卷积操作】卷积神经网络有哪些重要的技巧细节?

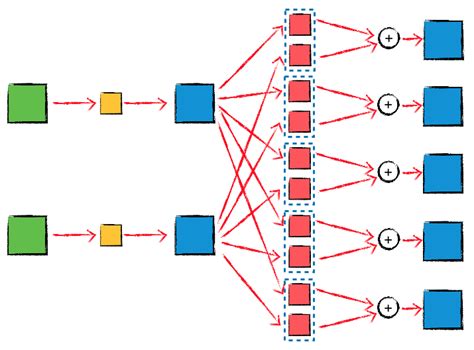

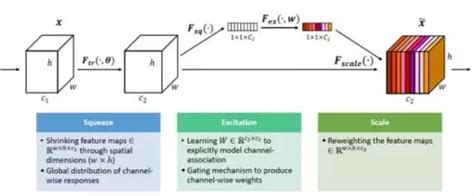

除了带你动手学深度学习,李沐大神还带你深挖卷积神经网络的各种实践「技艺」 。近日AWS的研究者研究了一系列训练过程和模型架构的改进方法,他们在多个神经网络架构和数据集上评估它们,并研究它们对最终模型准确率的影响 。自 2012 年 AlexNet 大展神威以来,研究者已经提出了各种卷积架构,包括 VGG、NiN、Inception、ResNet、DenseNet 和 NASNet 等,我们会发现模型的准确率正稳定提升 。

推荐阅读

- 电脑的本地连接不见了怎么办,网络连接不上怎么办

- 城市轨道交通车辆技术的就业方向

- 苍虫的学名

- 重庆专本贯通的政策

- 介词的用法口诀

- 最薄的手机有哪些,比较薄的手机有哪些

- 买吸尘器怎么挑选,想买个好用的吸尘器

- 忘记你笨重的大光圈镜头,景深镜头

- 安卓手机哪个牌子好,现在什么安卓手机好

- 中国人形机器人,类人机器人