【lmb633的博客,卷积核】如何理解空洞卷积?

CNN网络中在对图像进行下采样时,常常使用pooling操作,包括average pooling和max pooling 。其作用在仿照人的视觉系统进行降维,同时扩大了感受野(perceptual field) 。对卷积层提取的特征进行降采样,从而能够获取到更高级的特征 。此外pooling层也可以保证特征位置和旋转不变形 。

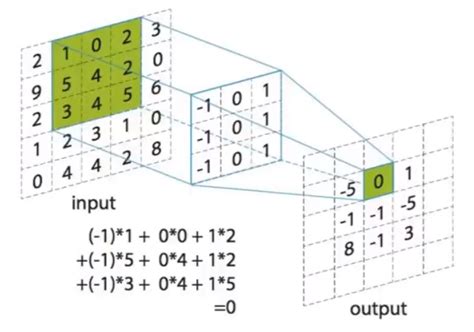

最后引入pooling还能起到降少网络参数,防止过拟合的问题 。但是采用pooling也有其缺点,在降采样的同时也会丢失一部分特征信息,损失了原始图像中的信息 。空洞卷积(diluted convolution)就是为解决pooling层的缺点而提出的 。它首先是针对图像语义分割而产生的一种卷积方法 。不同于一般的卷积,空洞卷积的卷积核更加“蓬松”,也就是在卷积核中加入空洞,以此来扩大感受野 。

引入了一个新的参数空洞率(dilation rate),即卷积核的间隔数目,正常卷积核的空洞率等于1 。如下图就是一个空洞率为2的3*3空洞卷积 。我们可以发现,空洞卷积不仅扩大了感受野降低了维度,同时没有增加计算量 。但是由于引入了一个超参数,就需要权衡每次卷积时的参数,如果空洞率过大,那么就很有可能捕捉不到图像中小物体的信息,因此再使用时需要设置好合适的空洞率 。

cnn卷积神经网络中的卷积核怎么确定?

卷积参数是模型学习出来的,卷积核的大小以及个数是人工来确定的,二维卷积卷积核大小一般是1*1,3*3,5*5,7*7这样奇数的 。卷积核的个数就是网络的channel数,常见的128 256 512这种,需要根据具体任务确定 。另外最近神经网络自动搜索结构非常火,最有名的就是谷歌的NASnet,采用某种启发式遍历来寻找对于特定数据集最优的网络结构 。

推荐阅读

- 拉黑也可以拨打的网络电话,网络电话下载

- 联想官,联想官方网站

- 苹果 大学生优惠,苹果校园体验店 如果在校园体验店买产品的话 有什么优惠

- opporeno7口碑怎么样,0ppor7用过的来说说怎么样这个价格入手值吗

- im在线客服系统,推荐下北京最好的在线客服软件

- 爱思助手扫描二维码下载,请问如何使二维码可以支持安卓苹果两种系统扫描下载对应系统的软件

- 苹果在校大学生教育优惠多少,12教育指的是什么

- 苹果手机图片13,为什么我的iPhone6相册里的照片显示时间是12年和13年

- oppo的全部型号,oppo都有哪几个系列都有什么型号

- 最好免费观看高清视频下载,推荐一些能免费看视频的手机视频播放器