高负荷下的人工智能GPU:平均寿命仅1-3年

【高负荷下的人工智能GPU:平均寿命仅1-3年】

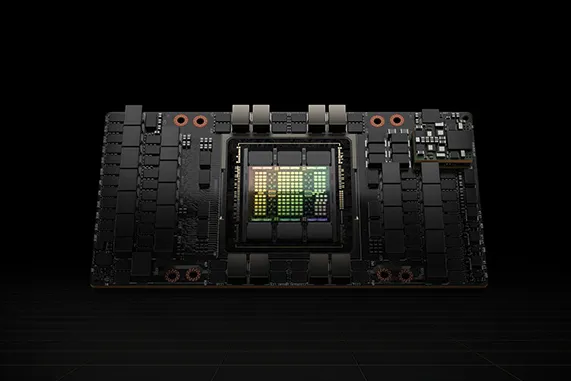

在当今人工智能(AI)和高性能计算(HPC)日益依赖的环境中 , 图形处理单元(GPU)已经成为数据中心的重要计算资源 。 然而 , 最近的报告指出 , 这些高价GPU在实际使用中的寿命可能仅为1到3年 , 给AI行业的经济带来了潜在的影响 。

根据Tech Fund引用的一位来自Alphabet的高级专家的观点 , 数据中心GPU的寿命受到其利用率的极大影响 。 现代数据中心中 , GPU主要用于执行AI训练和推理等高强度计算任务 。 在这种情况下 , GPU往往处于高负荷状态 , 导致其磨损速度远超其他硬件组件 。 云计算服务提供商(CSP)在运营中发现 , GPU的利用率通常维持在60%至70%之间 , 这种高负荷的工作环境进一步缩短了GPU的预期寿命 。

在这样的利用率下 , GPU的平均寿命一般在1到2年之间 , 最多可延长至3年 。 这一观点虽然尚未得到充分验证 , 但由于现代GPU的功耗通常达到700W或以上 , 确实给硅片带来了巨大的压力 , 这使得这种看法具备一定的可信度 。

为了延长GPU的使用寿命 , 降低其利用率被认为是一种有效的方法 。 然而 , 这样的做法会导致GPU的贬值速度减缓 , 进而影响到资本回收的效率 , 这对于大多数商业运营来说并不是理想的选择 。 因此 , 许多云服务提供商更倾向于维持GPU的高利用率 , 以实现最佳的投资回报 。

Meta在早些时候进行的一项研究表明 , 他们在训练Llama 3 405B模型时 , 使用了由16384个Nvidia H100 80GB GPU组成的集群 。 尽管该集群的模型浮点运算利用率(MFU)约为38% , 但在54天的训练过程中 , 发生了419次不可预见的故障 , 其中148次(约30.1%)是由各种GPU故障引起的 , 包括NVLink故障 , 而72次(约17.2%)则由HBM3内存故障引起 。 这表明 , 即使在相对较低的利用率下 , GPU也面临着显著的故障风险 。

Meta的研究结果显示 , 若以其故障率为依据 , H100 GPU的年度故障率约为9% , 而在三年内的年度故障率则约为27% 。 然而 , 随着GPU服役时间的延长 , 故障的频率可能会进一步增加 , 这给运营带来了不小的挑战 。

随着AI和HPC应用的不断发展 , 数据中心对GPU的需求只会持续增长 。 然而 , GPU的短寿命周期却使得数据中心的运营维护面临严峻考验 。 为了应对这一挑战 , 行业亟需开发更加耐用的GPU架构 , 寻找有效的管理和延长GPU使用寿命的方法 。

与此同时 , 数据中心运营商还需要重新评估其硬件更新策略 , 以适应不断变化的技术需求和日益增长的计算负载 。 以传统三年折旧期为基础的资本投资计划已显得不再现实 , 企业需转向短期投资回收计划 , 以应对可能的现金流压力 。

*免责声明:以上内容整理自网络 , 仅供交流学习之用 。 如有内容、版权问题 , 请留言与我们联系进行删除 。

推荐阅读

- 高通3纳米芯片发布,国产手机尴尬了,高端手机完全受制美国芯片

- 小米Pad 7 Pro体验:更高清的屏幕办公娱乐体验全面升级

- 想用六年不卡顿,可入手这5款手机,性能强配置高

- 好用又便宜的手机推荐,这三款真我手机可以优先考虑,配置高屏幕好

- 夏普AQUOS R9 pro发布:徕卡影像加持,提前抢占高端市场

- 小米15搭载超窄四等边阳光屏:定制M9发光材料 高亮低功耗

- vivo冲击高端,先在影像上交了一笔学费

- Arm要禁止高通做芯片,网友炸了

- 首发苍穹通信系统2.0创新双侧高低频电竞天线真我GT7 Pro参数曝光

- 2024年性价比高且质量好的华为手机,这3款可以优先考虑