在下游视觉场景中,小样本训练带来的是极高的训练速度,以及极低的训练成本。

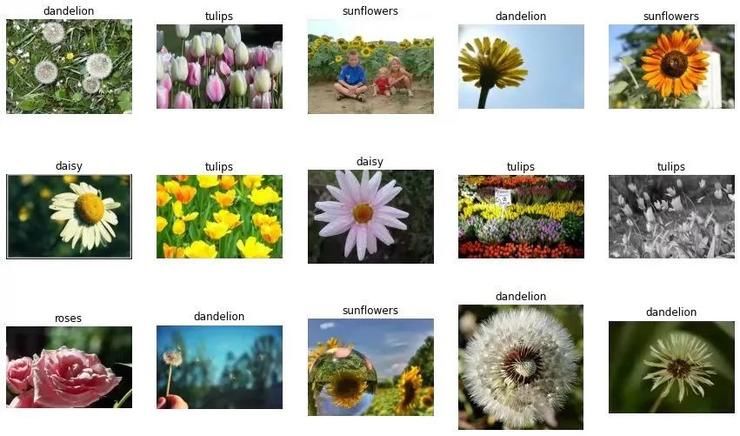

例如在花卉种类识别任务上,“书生“只需要每一类型的花卉提供两个训练样本,就能实现99.7%的准确率。

这个花卉数据集由102种英国常见的花组成,每个类别有40至258张图片。其中包含有很大的比例、姿势和光线变化。

102个类别的花卉数据集:https://www.robots.ox.ac.uk/~vgg/data/flowers/102/index.html

通用视觉平台,已正式开源如此强大的通用视觉训练模型已经正式开源!

更关键的是,连同上述讲到的标签数据集、网络结构以及评测基准,均在OpenGVLab被统一打包开源。

其中的网络结构除了MetaNet,还包含大家普遍使用的ResNet, MobileNet, ViT, EfficientNet等,以满足不同场景的应用,赋能计算机视觉。

然而,「书生」的布局不止于此。

OpenGVLab将与上海人工智能实验室此前发布的OpenMMLab、OpenDILab一道,共同构筑开源体系OpenXLab,持续推进通用人工智能的技术突破和生态构建。

一位已经使用过此次开源平台的自动驾驶算法研究员表示:“书生系列模型充分覆盖了从移动可部署的小模型,到超大规模自研结构,为行业带来了希望,尤其是它的收敛速度,大幅节省了训练开销,是技术落地的一大助推器。“

不仅是自动驾驶领域,智慧城市、智慧医疗、智慧交通,以及千千万万其他的智能化领域,都将获得通用视觉模型带来的技术红利。

一位腾讯研究员大赞OpenGVLab:“能把这么大的工作开源出来真的是业界良心。简单用了一下,确实比CLIP要更fine-grained(细粒度更高)。”

而来自学界的师生也对此感慨有加:“OpenGVLab集成了大量各种量级的state-of-the-art(先进)模型,使用起来更得心应手,省去了对不同codebase、不同模型繁琐调研的烦恼。”

换句话说,当那些代码和公式脱去了枯燥乏味的外衣,人们才发现了真正的创造力。而这,也是技术创新与平台开源的魅力所在。

往近了说,用这款通用视觉模型打比赛,怕不是奖金多到飞起!在技术生产力的道路上,又诞生了一个致富小妙招!

目前,“书生”技术报告《INTERN: A New Learning Paradigm Towards General Vision》已在arXiv平台发布。

论文地址:arxiv.org/abs/2111.08687

欢迎大家亲自挖宝!

【 模型|只需要十分之一数据,就能通关四大视觉任务,居然还开源了!】雷峰网雷峰网

推荐阅读

- 销售额|为什么聪明人买房只买89平米?

- 杨现领|浙江:一女子租住公寓空调是残次品只能住酒店,公寓管家不给报销

- |农民在宅基地建房,需要审批吗?加盖楼层属于违建吗?

- |公寓价格只有住宅价格的一半,我要不要买公寓房呢?

- 武汉|重磅!只认贷不认房!南昌限购区首套首付降至2成,奈何只针对……

- 长沙|交房,只能算开发商的及格线!

- 大牌|新家厨具选购只要零头价格!原来这些代工厂本身也是性价比超高的大牌

- 购房置业|如今的社会现状。房地产商是否需要改变观念?

- 商品房|购买期房能抵押贷款吗?三大风险需要提前知道!

- |开发商降价前的五个信号,只是好多人没干过,赶紧收藏啊